L'Intelligence Artificielle transforme votre patron en « Panoptique » : un rapport choc dénonce la surveillance des salariés

Par Joe Wilkins .Publié le

2025/09/29 17:28

Septembre. 29, 2025

Alors que le monde retient son souffle en attendant de voir si l'industrie technologique américaine peut donner naissance à une intelligence artificielle de niveau humain – réécrivant par là même le contrat social et l'économie – des experts alertent : les versions actuelles de cette technologie redessinent déjà le monde du travail de manière insidieuse et dangereuse.

Cette semaine, la Confédération Européenne des Syndicats (CES), qui représente près de 45 millions de travailleurs dans 40 pays européens, a publié un rapport exhaustif sur l'impact inquiétant des algorithmes qui contrôlent de plus en plus le lieu de travail.

Intitulé "Négocier l'Algorithme" ("Négocier l'Algorithme"), ce pavé de 70 pages expose les faits fondamentaux de la gestion algorithmique : l'utilisation de programmes d'IA pour superviser les salariés. Loin d'être une simple dystopie, la CES met en garde contre la montée alarmante de cette technologie. En effet, une étude récente a révélé que 79% des lieux de travail au sein de l'Union Européenne — et 90% aux États-Unis — utilisent déjà au moins un outil de gestion algorithmique pour encadrer le personnel.

Si la plupart d'entre nous lèvent les yeux au ciel lorsque nos supérieurs installent un nouveau logiciel, la gestion algorithmique modifie déjà drastiquement la dynamique du pouvoir au bureau. Et comme le souligne la CES, ces changements ne semblent jamais s'opérer en faveur des travailleurs.

Les Sept Risques de la Gouvernance par l'IA

Le guide de la CES identifie sept risques – ou fonctions, selon le point de vue – qui découlent de la gouvernance par l'IA :

Attributions de travail discriminatoires.

Salaires fluctuants et imprévisibles.

Perte d'autonomie pour le travailleur.

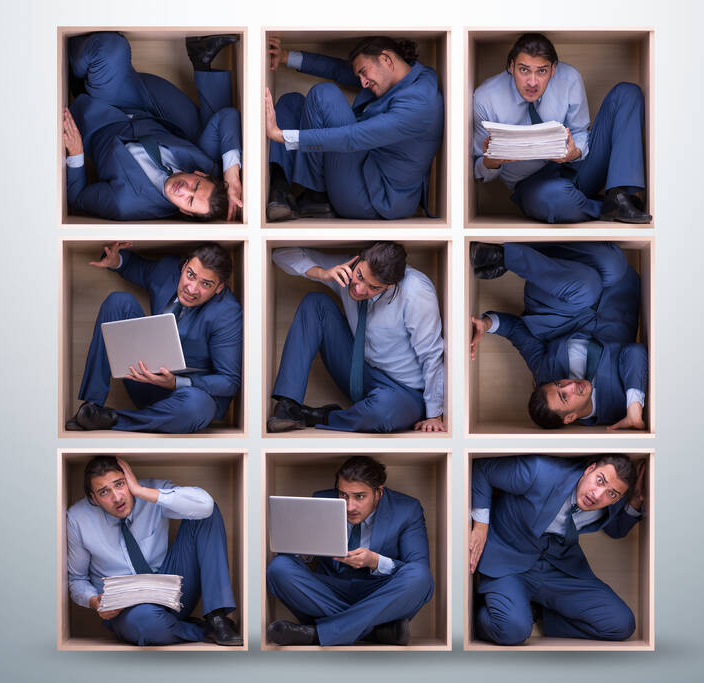

Surveillance constante et omnisciente.

Évaluations de performance déraisonnables.

Sanctions automatisées (ou punition algorithmique).

Défaut ou non-paiement.

« La gestion algorithmique est utilisée pour déterminer la répartition du travail et les salaires de manière généralement opaque et souvent discriminatoire », indique le rapport. « Les travailleurs doivent faire face à des formes de surveillance intensives qui réduisent l'autonomie et minent la vie privée. Les travailleurs sont évalués sans transparence et sans aucune possibilité d'intervention de leur part ».

« Le pire, peut-être, » poursuit-il, « c'est que les travailleurs sont confrontés à des sanctions déterminées par l'algorithme, pouvant aller jusqu'à la perte de leur emploi, parfois sans jamais pouvoir communiquer avec un supérieur humain. »

Alors que la gestion algorithmique est solidement ancrée dans les emplois précaires et à bas salaires (chauffeurs de VTC, entrepôts, travail en ligne), elle s'étend rapidement à des secteurs comme la thérapie, le droit et la santé. Autrement dit, le fait que vous ne gagniez pas votre vie via une application aujourd'hui ne signifie pas que ce ne sera pas le cas demain.

Comment lutter contre le Panoptique Numérique

Heureusement, la CES propose des solutions pour contrer ce "Panoptique de l'IA". La première est une liste pratique des victoires déjà remportées par les travailleurs à travers l'UE. On trouve notamment le cas du Danemark, où l'application de ménage Hilfr a accepté de fournir aux salariés une explication complète de toutes les décisions prises par algorithme, s'appuyant sur des acquis déjà négociés comme un salaire minimum et des congés maladie payés.

Pour les cas où l'entreprise est moins disposée à partager les données de ses systèmes, le rapport met en lumière des tactiques que les travailleurs peuvent utiliser pour « craquer l'algorithme ». Cela commence par une demande polie de données d'entreprise, conformément aux lois européennes sur les données.

Si cela échoue, il existe des méthodes moins officielles, notamment :

La technique du "compte fantôme" (sock-puppet): lorsqu'un travailleur de la gig economy crée plusieurs comptes pour comparer les données avec son profil principal.

La rétro-ingénierie (reverse engineering): une plongée plus laborieuse dans les données brutes.

Les "applications contre-mesures" (counter apps): comme UberCheats, utilisées pour auditer le logiciel de gestion algorithmique.

En conclusion, le rapport affirme que la lutte contre la gestion algorithmique ne consiste pas à « réinventer la roue, mais à ajouter de nouveaux rayons ».

Notez ce sujet