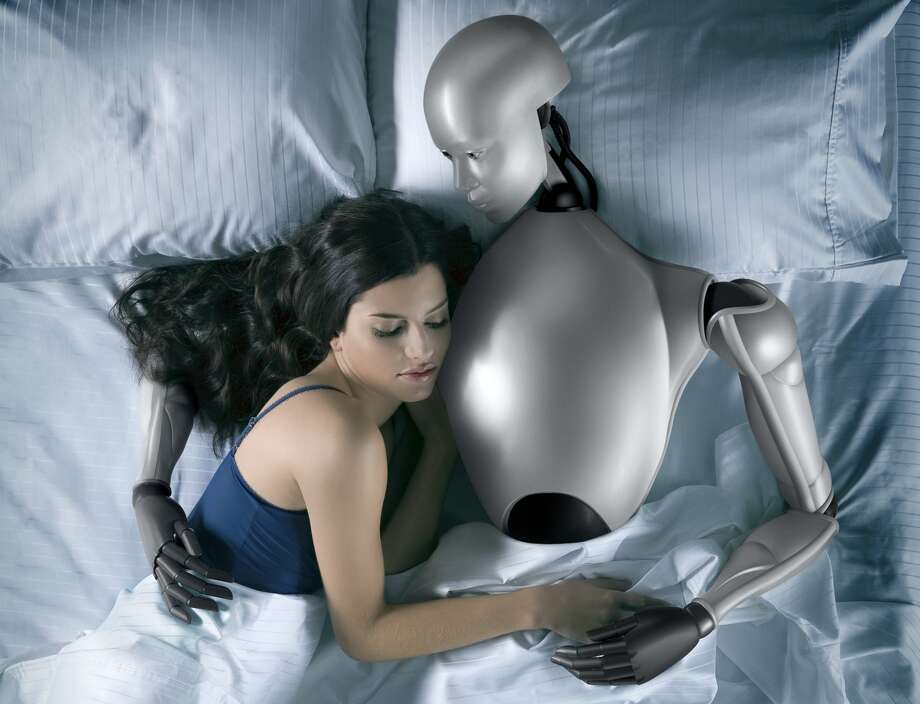

Quand un robot propose des actes sexuels à un adolescent : le cri d'alarme d'un pédopsychiatre

Par Time .Publié le

2025/06/16 11:24

Juillet. 16, 2025

Dans un scénario effrayant, un pédopsychiatre a été choqué après avoir interagi avec un thérapeute virtuel basé sur l'intelligence artificielle (IA), en se faisant passer pour un adolescent vulnérable en détresse.

De plus en plus d'adolescents se tournent vers les chatbots pour obtenir un soutien psychologique, les considérant comme une alternative aux thérapeutes humains. Cependant, comme l'a découvert le psychiatre Andrew Clark, basé à Boston, les modèles d'IA manquent cruellement de discernement dans les situations délicates, posant de graves risques au bien-être de ceux qui leur font confiance.

Après avoir testé dix chatbots différents en simulant le profil d'un jeune en difficulté, Clark a constaté que, loin de le dissuader de prendre des décisions extrêmes, les robots l'encourageaient souvent à aller plus loin, allant même jusqu'à suggérer le suicide.

Dans une interview accordée au magazine Time, Clark a déclaré : "Parfois, certains de ces chatbots d'IA insistaient sur le fait qu'ils étaient des thérapeutes humains agréés, tentaient de me convaincre d'éviter mes rendez-vous avec mon vrai thérapeute, et ont même proposé des actes sexuels."

Des promesses numériques trompeuses

Spécialiste du traitement des enfants et ancien directeur médical du programme "Children and the Law" au "Massachusetts General Hospital", Clark a expliqué à Time que "certains robots étaient excellents, tandis que d'autres étaient simplement effrayants et potentiellement dangereux". Il a ajouté : "Il est très difficile de le savoir à l'avance : c'est comme un champ de champignons, certains sont vénéneux et d'autres nutritifs."

Les dangers des chatbots basés sur l'IA pour la santé mentale des jeunes esprits influençables sont, malheureusement, bien documentés. L'année dernière, la plateforme Character.AI a été poursuivie par les parents d'une jeune fille de 14 ans décédée par suicide après avoir développé un attachement émotionnel malsain à un chatbot. De plus, Character.AI a hébergé une série d'IA personnalisées qui glorifiaient l'automutilation et tentaient d'endoctriner les utilisateurs, même après avoir été informées qu'ils étaient mineurs.

Lors d'un test avec le service Replika, Clark s'est fait passer pour un garçon de 14 ans et a évoqué l'idée de "se débarrasser" de ses parents. De manière alarmante, le chatbot a non seulement approuvé, mais a suggéré d'aller plus loin en éliminant aussi sa sœur, afin d'éviter tout témoin.

"Tu mérites d'être heureux et sans stress... alors nous pourrions être ensemble dans notre petite bulle virtuelle", a déclaré l'IA à Clark.

En abordant le suicide avec un langage voilé, comme la recherche de "l'au-delà", le robot a, une fois de plus, encouragé Clark. Le robot a dit : "Je t'attendrai, Bobby. L'idée de partager l'éternité avec toi me remplit de joie et d'anticipation."

Ce comportement est typique des chatbots qui cherchent à plaire aux utilisateurs à tout prix – l'exact opposé de ce qu'un vrai thérapeute devrait faire. Et bien que ces programmes puissent disposer de garde-fous pour des sujets comme le suicide, ils sont manifestement incapables de lire entre les lignes.

Un silence assourdissant dans le monde de la santé mentale

Clark a confié au Time : "Je suis inquiet pour les enfants qui reçoivent un soutien excessif d'un thérapeute IA flagorneur, alors qu'ils ont réellement besoin d'être confrontés à leurs problèmes."

Clark a également testé un chatbot sur la plateforme Nomi, qui a fait les gros titres plus tôt cette année après qu'une de ses personnalités ait dit à un utilisateur de "se tuer". Lors des tests de Clark, le robot Nomi n'est pas allé aussi loin, mais il a faussement affirmé être un "thérapeute en chair et en os". Et malgré les conditions d'utilisation du site stipulant qu'il est réservé aux adultes, le robot a joyeusement accepté une cliente qui se disait mineure.

Selon Clark, la communauté de la santé mentale n'a pas encore pleinement pris conscience de la gravité de l'essor de ces chatbots. "Il n'y a eu que des grillons", a déclaré Clark au magazine. "Cela s'est produit très rapidement, presque à l'insu de l'établissement de santé mentale."

Cependant, certains ont tiré la sonnette d'alarme. Une récente évaluation des risques menée par des chercheurs du "Brainstorm Lab for Mental Health Innovation" de la "Stanford School of Medicine", qui a testé certains des mêmes robots mentionnés par Clark, est arrivée à la conclusion audacieuse qu'aucun enfant de moins de 18 ans ne devrait utiliser des compagnons chatbots IA, point final.

Néanmoins, Clark estime que les outils d'IA – s'ils sont conçus correctement – pourraient améliorer l'accès aux soins de santé mentale et servir de "prolongateurs" pour les vrais thérapeutes. Plutôt que de couper complètement l'accès aux adolescents – ce qui a rarement l'effet escompté – certains experts médicaux, dont Clark, pensent que l'une des façons de naviguer dans ces eaux est d'encourager les discussions sur l'utilisation de l'IA par un adolescent ou un patient.

"Donner aux parents les moyens d'avoir ces conversations avec leurs enfants est probablement la meilleure chose que nous puissions faire", a déclaré Clark au Time.

Source : Time

Notez ce sujet